Beiträge

Themengruppen

Recherche

Service

- Was ist Wissensmangement?

- Open Journal of Knowledge Management

- Artikel-Guidelines

- Newsletter

- Kalender

- Wissensmanagement-Anbieter

- Partner

- Mediadaten

Community

Sponsoren

- Personalvermittler, die einerseits stellenausschreibende Unternehmen als Kunden gewinnen wollen und daher an ausgeschriebenen Stellen interessiert sind – die andererseits aber auch wechselwillige Kandidaten suchen, um den Personalbedarf dieser Unternehmen zu befriedigen.

- Zeitungsverlage, die Meldungen von Agenturen, Journalisten, Blogs, Tweets, etc. klassifizieren, sichten und für ihre Nachrichten aufbereiten wollen.

- Marktforscher, die für ihr Unternehmen relevante Trends unter Kunden oder Benutzern identifizieren und deren Veränderungen erkennen müssen.

- Wettbewerbsbeobachter, die neu entstehende Konkurrenten identifizieren und die Aktivitäten von Konkurrenzunternehmen beobachten müssen.

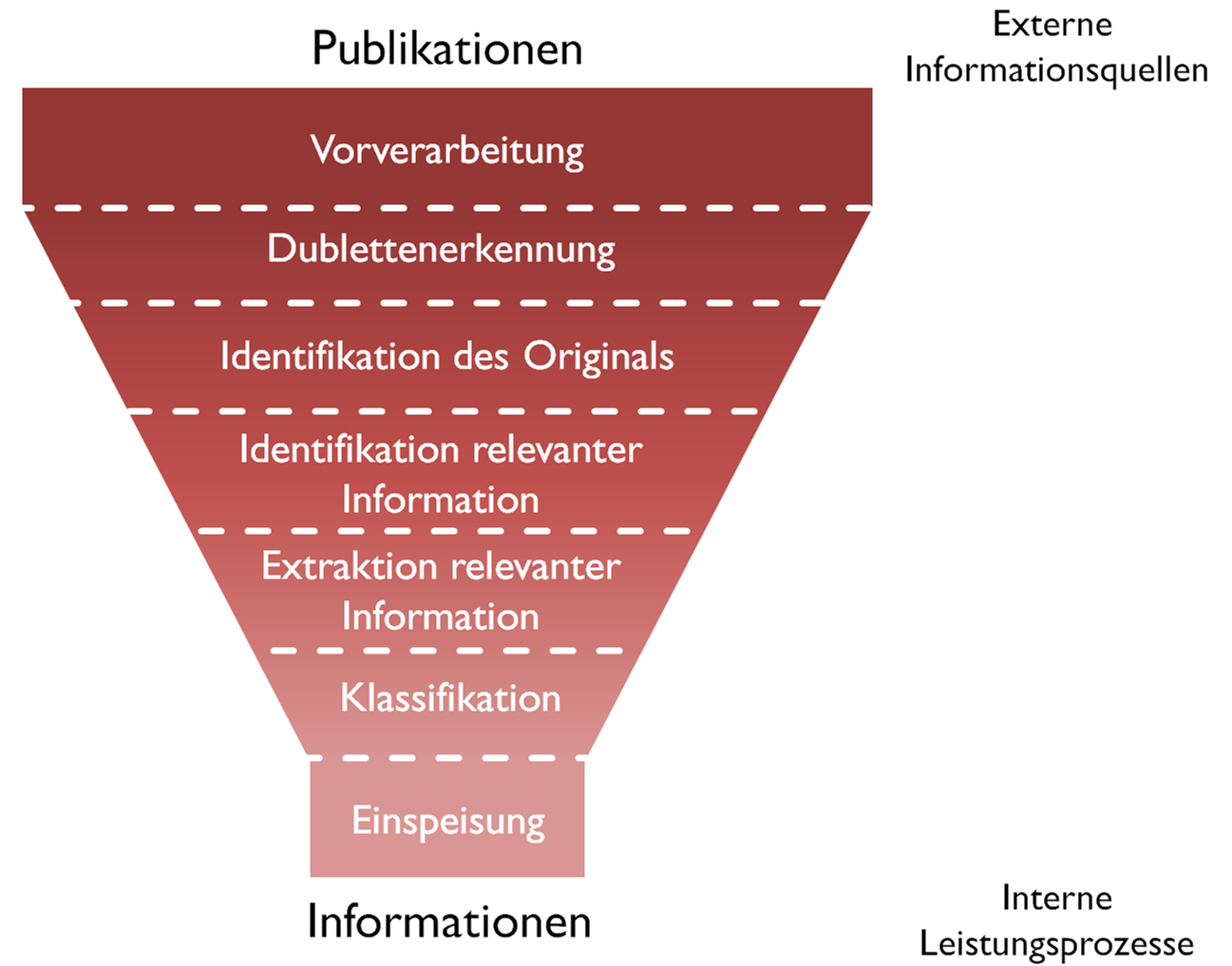

- Auswahl und Nutzung einer oder mehrerer hochwertiger Informationsquellen (Vollständigkeit, Qualität)

- Erkennung von redundanten Publikationen (identisch, dupliziert)

- Identifikation der originären Publikation

- Identifikation und Extraktion der von den Leistungsprozessen benötigten, relevanten Informationen

- Vermittlung der unterschiedlichen Sprachen von Autor und Nutzer

- Klassifikation der Informationen und Publikationen

Semantische Filterung – Ein Werkzeug zur Steigerung der Effizienz im Wissensmanagement

10. Juni 2013 von Dr. Thomas HoppeDieser Artikel adressiert einen Randbereich des Wissensmanagements: die Schnittstelle zwischen Unternehmens-externen Informationen im Internet und den Leistungsprozessen eines Unternehmens. Diese Schnittstelle ist besonders für Unternehmen von Interesse, deren Leistungsprozesse von externen Informationen abhängen und die auf diese Prozesse angewiesen sind. Wir zeigen an zwei Fallbeispielen, dass die inhaltliche Filterung von Informationen beim Eintritt ins Unternehmen ein wichtiges Werkzeug darstellt, um daran anschließende Wissens- und Informationsmanagementprozesse effizient zu gestalten.

Dieser Beitrag wurde im Open Journal of Knowledge Management, Ausgabe VII/2013 veröffentlicht.

Einleitung

Die Digitale Revolution hat neben vielen Vorteilen, die unser Leben erleichtern, auch Nachteile mit sich gebracht. Durch die mit ihr einhergehende Informationsexplosion ist eine Informationsüberflutung entstanden, die es erschwert, den Überblick über die wirklich relevanten Informationen zu behalten.

Diese Informationsexplosion wird durch drei Quellen gespeist: die Einfachheit der Produktion und Veröffentlichung von Informationen durch Jedermann, die Vervielfältigung ein- und desselben Inhalts durch voneinander unabhängige Dienste und die Verfügbarkeit einer kontinuierlich wachsenden Menge von Informationsquellen.

Das Wissensmanagement adressiert als Managementdisziplin den Umgang mit Wissen in Unternehmen. Der Hauptfokus wird hierbei in der Regel auf die Bewahrung, die Weitergabe und die Verfügbarmachung von Wissen und Informationen gelegt, mit dem Ziel, Arbeitsprozesse aufrecht zu erhalten oder effizienter und effektiver zu gestalten.

Vor dem Hintergrund der skizzierten Informationsflut scheint – unserer Kenntnis nach – der Selektion und Reduktion von Informationen im Kontext des Wissensmanagement bisher noch wenig Aufmerksamkeit geschenkt worden zu sein. In diesem Artikel adressieren wir diesen Randbereich des Wissensmanagements: die Schnittstelle zwischen Unternehmens-externen Informationen im Internet und den Leistungsprozessen eines Unternehmens. Diese Schnittstelle ist besonders für Unternehmen von Interesse, deren Leistungsprozesse von externen Informationen abhängen und die auf diese Prozesse angewiesen sind. Beispiele für solche Unternehmen sind:

Diese Unternehmen sind von externen Informationen abhängig, können aber die drei externen Ursachen der Informationsexplosion selber nicht beeinflussen. Sie können darauf lediglich reagieren und an der Schnittstelle zu ihren internen Prozessen Mechanismen einsetzen, um die Informationsflut einzudämmen. Eine wichtige Aufgabe des Wissensmanagements an dieser Schnittstelle ist es, die externen Informationsströme beim Eintritt in den Unternehmensbereich zu filtern und zu kanalisieren, damit die daran anschließenden Leistungsprozesse effizient und effektiv darauf aufsetzen können.

Informationsfilterung

Informationen werden in erster Linie von Menschen für Menschen produziert. Sofern diese Informationen nicht unmittelbar in ein System eingespeist werden, handelt es sich in der Regel um nicht oder nur schwach strukturierte Informationen. Dies erschwert die Filterung, da die Textstellen, an denen relevante Informationen zu finden sind, nur grob durch den Kontext definiert werden und damit deren Extraktion erschwert wird. Darüber hinaus verwenden Autoren und Nutzer der Informationen mit großer Wahrscheinlichkeit unterschiedliche Begriffe um die Inhalte zu präsentieren resp. zu identifizieren.

Eine intelligente Filterung von un- oder semi-strukturierten Informationen muss daher je nach Anwendungsfall die folgenden Anforderungen berücksichtigen:

Der Filterungsprozess lässt sich wie folgt skizzieren:

Fallbeispiel: Stellenanzeigen

Personalberater sind einerseits daran interessiert, viele Kandidaten zu kennen, die sie Unternehmen für die Besetzung einer Stelle vorschlagen können, andererseits benötigen sie Informationen über Unternehmen, die vakante Stellen besetzen wollen. Während es für die Suche nach Kandidaten keine einfach und legal zu durchsuchenden Quellen gibt, liefern Stellenportale und Jobsuchmaschinen tagtäglich eine große Menge von vakanten Stellen.

Je nach Spezialisierung des Personalberaters können das pro Werktag durchaus zwischen 200 und 450 Anzeigen sein.

Diese Anzeigen reichen von ernst gemeinten Ausschreibungen über Anzeigen, die wiederholt veröffentlicht werden, über Dubletten von Anzeigen, Anzeigen die andere Personalberater schalten, um ihren Kandidatenpool zu erweitern, über Anzeigen die Unternehmen aus Prestigegründen veröffentlichen bis hin zu wiederholt ausgeschriebenen, un- bzw. schwer besetzbaren Stellen. Hierbei werden Stellen für die unterschiedlichsten Qualifikationsniveaus ausgeschrieben, von Praktika und Stellen für Bachelor- oder Masterarbeiten, über Stellen für Berufseinsteiger und erfahrenem Fachpersonal bis hin zu Führungspositionen. Für Personalberater sind insbesondere die letzten beiden Kategorien am lukrativsten, da ihre Vermittlungsprovision in der Regel vom Jahresgehalt der vermittelten Kandidaten abhängt.

Für einen Personalberater ist es daher wichtig, möglichst nur die neusten, ernstgemeinten Ausschreibungen für Fach- und Führungskräfte vorgelegt zu bekommen. Dubletten sollten vermieden werden, bereits bekannte Anzeigen sollten als solche erkannt und markiert werden, Anzeigen von Konkurrenten sollten ignoriert werden, ebenso wie Anzeigen zu „unterqualifiziertem“ Personal. Auf jeden Fall aber sollten möglichst alle und auf jeden Fall nur die neusten Ausschreibungen identifiziert werden. Für den Personalberater ist Zeit hier Geld, denn wenn er der Erste ist, der eine neue, offene Stelle findet, erhöht er seine Chancen dem den Besetzungszuschlag zu erhalten.

Das sind die rein technischen Randbedingungen, die eine Filterung erfüllen muss. Daneben gibt es aber auch inhaltliche Randbedingungen. Bei der Filterung sollten möglichst die vom Bewerber geforderten „Kompetenzen“ ermittelt werden, denn sie bilden die zentralen Kriterien, nach denen der Personalberater seinen Kandidatenpool nach passenden Kandidaten durchforsten kann. Andererseits kann es Kompetenzbereiche geben, die nur „nice to have“ sind oder an denen der Personalvermittler gar nicht interessiert ist. Diese sollten entsprechend identifiziert und klassifiziert werden.

Im Fall eines unserer Kunden haben wir sowohl die Positionsbezeichnungen für die Identifikation von Fach- und Führungskräften als auch die Kompetenzen in einer Ontologie [1] modelliert. Hierbei wurden sowohl positive Identifikatoren als auch negative Identifikatoren, die dem Ausschluss bestimmter Positionen dienen, modelliert, als auch die Kriterien die zur Unterscheidung von zentralen und weniger zentralen Kompetenzen dienen.

Darüber hinaus haben wir ein Verfahren für eine „semantische Mustererkennung“ entwickelt, implementiert und eingesetzt, das es einerseits erlaubt, regelbasierte Entscheidungen über den Relevanzgrad bestimmter Positionen und Kompetenzen zu treffen, als auch die erforderlichen Kompetenzen zu extrahieren und zu klassifizieren.

Mit dem semantischen Filterverfahren konnte der Personalberater bereits in der ersten Projektphase eine Stelle identifizieren und besetzen, die er ohne das Verfahren – lt. seiner Aussage – vermutlich nicht gefunden hätte. Kurz nach der regulären Inbetriebnahme konnte er auf diese Weise innerhalb einer Woche zwei Stellen besetzen. Es läuft seit einem dreiviertel Jahr im regulären Betrieb, reduziert die Zahl der zu sichtenden Anzeigen auf rd. 50 pro Tag und konnte – bei leicht rückgängigem Arbeitsmarkt – den Personalberater vor einem Umsatzrückgang bewahren. Nach Aussage des Personalberaters arbeitet das Verfahren „gefühlsmäßig“ zu 90% korrekt.

Für dieses Verfahren ist eine Schnittstelle zu den Werkzeugen und Prozessen des Personalberaters vorgesehen, die es erlauben aktuelle, relevante Stellenausschreibungen an die Mitarbeiter des Personalberaters zu delegieren und den Status des Kundenakquiseprozesses zwischen ihnen zu kommunizieren. Das Filterverfahren dient somit als Werkzeug, um die Verfügbarmachung von Informationen über vakante Stellen und die Weitergabe von Wissen über den Status des Akquiseprozesses durch eine Beschränkung auf die wesentlichsten, aktuellsten, relevanten Informationen zu vereinfachen.

Fallbeispiel: Nachrichten

Jeden Tag erreichen Leser, Unternehmen und Zeitungsverlage eine große Anzahl von Nachrichten. Leser und Unternehmen sind in der Regel nicht an allen Meldungen interessiert. Zeitungsverlage selber müssen aus der Masse der Agenturmeldungen diejenigen ausfiltern, die sie ihren Lesern präsentieren möchten.

Das Filtern ist hier natürlich stark von den Interessen des jeweiligen Interessenten abhängig. Normale Leser sind eher an lokalen Nachrichten, an bestimmten Ereignissen, Sachthemen oder Themengebieten interessiert sein. Unternehmen sind an Marktinformationen, Pressemitteilung oder Nachrichten über ihre Konkurrenz interessiert, während Zeitungsverlage die Nachrichten gezielt für das Marktsegment ihrer Leser filtern und aufbereiten müssen. Allen gemein ist, dass die Anzahl der relevanten Nachrichten in der Regel kleiner ist als die Gesamtmenge der Nachrichten im jeweilig genutzten Nachrichtenstrom.

Für den Bereich der lokalen Nachrichten haben wir einen Demonstrationsdienst aufgesetzt, der lokale Nachrichten aus den öffentlichen Nachrichten-Feeds der großen 6 Berliner Tageszeitungen unter Zuhilfenahme von geografischem Hintergrundwissen herausfiltert, anhand dieses Hintergrundwissens den Ort oder die Orte des Geschehens (die Orte, von denen die Meldung handelt) bestimmt, für diese Orte die geografischen Koordinaten ermittelt und die Nachrichten auf einer Karte an diesen Orten visualisiert. Dieser Dienst ist sowohl als „location-based augmented reality chanal“ [2] als auch im Web unter http://www.ontonym.de/newsmap.html verfügbar

aufgesetzt, der lokale Nachrichten aus den öffentlichen Nachrichten-Feeds der großen 6 Berliner Tageszeitungen unter Zuhilfenahme von geografischem Hintergrundwissen herausfiltert, anhand dieses Hintergrundwissens den Ort oder die Orte des Geschehens (die Orte, von denen die Meldung handelt) bestimmt, für diese Orte die geografischen Koordinaten ermittelt und die Nachrichten auf einer Karte an diesen Orten visualisiert. Dieser Dienst ist sowohl als „location-based augmented reality chanal“ [2] als auch im Web unter http://www.ontonym.de/newsmap.html verfügbar

Die „semantische Filterung“ der täglich durchschnittlich 530 Nachrichten erfolgt hierbei auf der Basis eines Informationsmodells über die Stadt Berlin und deren Bezirke, Ortsteile, Ortslagen und Straßen. Alles in allem sind das über rund 10.500 Informationsentitäten und deren Zusammenhänge. Die Filterung identifiziert hierbei die durchschnittlich 20% der Nachrichten, die sich überhaupt auf Berlin beziehen und klassifiziert bzw. lokalisiert die Nachrichten anhand der Orte, auf die sich die Nachricht bezieht.

Was wir für Ortsinformationen realisiert haben, lässt sich vom Prinzip her auch auf andere inhaltliche Informationen wie z.B. die Zuordnung zu Ereigniskategorien oder Themengebieten übertragen. Wesentlich hierbei ist, dass Hintergrundwissen benötigt wird, um entsprechende Klassifizierungen der Nachrichten zu ermitteln. Anhand dieser Klassifikation können dann die Nachrichten gefiltert werden, um die Flut der durch Menschen zu verarbeitenden Informationen zu begrenzen.

Dieser Dienst selbst hat direkt natürlich nichts mit Wissensmanagement zu tun, da er primär für Zeitungsleser ausgelegt ist. Dieselben Prinzipien jedoch, die für die Erkennung relevanter Ortsbezeichnungen im Text und die Klassifikation anhand von Hintergrundwissen verwendet werden, sind übertragbar auf die Filterung von Nachrichten anhand vordefinierter Interessen über Unternehmen oder für die Filterung, Klassifikation und Verortung von Nachrichten für Zeitungsverlage [3].

Im Rahmen der Evaluation des Verfahrens, für das wir Recall- und Precision-Werte [4] zwischen 85-100% ermitteln konnten, haben wir auch den zeitlichen Aufwand erfasst, mit dem Menschen dieselbe Tätigkeit intellektuell durchführen.

Pro Nachricht dauert es im Schnitt rund eine Minute, bis ein Mensch erfasst hat, ob sich eine Nachricht auf Berlin bezieht und falls ja, auf welche Orte. Pro Nachricht werden im Schnitt 1,7 Orte genannt. Rechnet man für den Prozess der manuellen Geocodierung nochmals eine Minute hinzu [5], so kommt man bei durchschnittlich rd. 90 Nachrichten pro Berliner Tageszeitung pro Tag auf rund 4 Stunden, die pro Zeitung ein Redaktionsmitarbeiter täglich alleine für die Geokodierung aufwänden müsste.

Hieraus wird ersichtlich, dass durch den Einsatz semantischer Filtertechnologien als Vorverarbeitungsschritt und für die automatisierte Geocodierung sowohl Geld als auch Nerven geschont werden können.

Fazit - Informationsfilterung und Wissensmanagement

Der Fokus des Wissensmanagements liegt in der Regel auf der Verfügbarmachung und Weitergabe von Wissen. Eine technische Unterstützung des Wissensmanagements zielt hierbei in der Regel auf die Speicherung und das Retrieval von Informationen ab. Die Auswahl aber, welche Informationen „wissenstragend“ sind, welche aufzubewahren und zu speichern sind, obliegt immer noch dem Menschen. Sofern es sich um Informationen handelt, die nur im Unternehmen selbst generiert werden, muss die Relevanz der Informationen nur selten hinterfragt werden. Die Informationsmengen bleiben – selbst wenn sie groß sind – noch beherrschbar.

Anders aber ist es, wenn die Information von außen kommt und nicht nur von einem informationsproduzierenden Unternehmen oder Dienst stammt. Durch die Potenzierung der Informationen kann ohne technische Unterstützung kein Mitarbeiter mehr alleine der Informationsflut Herr werden. Eine Vorfilterung wird unumgänglich. Diese Vorfilterung muss zu einem gewissen Grad entscheiden können, ob eine Information für die anschließenden Leistungsprozesse potentiell relevant ist und ggf. zwischen der Unternehmens-externen Sprachwelt und der Sprachwelt des Unternehmens übersetzen können. Für eine intelligente Interpretation von Begriffen in nicht oder schwach strukturierten Texten werden Verfahren benötigt, die neben einer reinen „named entity recognition“ auch den Kontext von Begriffen berücksichtigen und aus diesem Kontext zusätzliche Informationen extrahieren können. Um diese Aufgaben effizient in einem Durchgang erledigen zu können haben wir ein Verfahren entwickelt, mit dem wir quasi eine „semantische Mustererkennung“ durchführen können. Verfahren die dies leisten können, benötigen Hintergrundwissen über die Begriffswelt, Indikatoren – in Form von Begriffen – über die Relevanz und Irrelevanz von Informationen, Indikatoren, welche Informationen zu extrahieren bzw. zu ignorieren sind und die Beschreibung von Kontextmustern, in denen diese Informationen auftreten können.

Fußnoten

[1] Mit Semantik wird, im Gegensatz zu Syntax und Pragmatik, die Bedeutung sprachlicher Äußerungen bezeichnet. Im Kontext der Informatik wird die Bedeutung von Zeichenketten entweder mathematisch über eine Interpretationsfunktion über einem Individuenbereich definiert oder im Kontext der Wissensrepräsentation durch die Beziehung zwischen Begriffen. Die Basis für semantische Verfahren bildet in der Regel eine explizite Repräsentation von Begriffsbeziehungen in Form von Synonymlisten, Taxonomien, Thesaurie oder Ontologien.

[2] NewsMap ist als Augmented Reality „Kanal“ oder „Welt“ für den Raum Berlin über die Apps „wikitude“ und „junaio“ auf den meisten Smartphones und Tablets verfügbar. Durch Scannen der QR-Codes am Ende des Artikels (ggf. mit vorheriger Installation der Apps) gelangen Sie direkt zum NewsMap Dienst.

[3] Derzeit wird der NewsMap-Dienst von zwei Zeitungsverlagen bzgl. eines verlagsinternen Einsatzes evaluiert.

[4] http://de.wikipedia.org/wiki/Beurteilung_eines_Klassifikators#Anwendung_im_Information_Retrieval

[5] Die Ortsbezeichnung muss aus dem Text kopiert werden, in ein System zur Bestimmung der Geokoordinaten eingespeist werden, ggf. nochmals disambiguiert werden, um dann die Geokoordinaten wieder mit der Nachricht in Verbindung zu bringen.

Anhang

QR Code 1: Zugriff über wikitude

QR Code 1: Zugriff über wikitude

QR Code 2: Zugriff über junaio

QR Code 2: Zugriff über junaio

Kommentare

Das Kommentarsystem ist zurzeit deaktiviert.

Schlagworte

Dieser Beitrag ist den folgenden Schlagworten zugeordnet