Beiträge

Themengruppen

Recherche

Service

- Was ist Wissensmangement?

- Open Journal of Knowledge Management

- Artikel-Guidelines

- Newsletter

- Kalender

- Wissensmanagement-Anbieter

- Partner

- Mediadaten

Community

Sponsoren

Content Management - Anforderungen und Nutzen

23. Oktober 2001 von Gebhard DettmarDieser Beitrag ist der erste in einer Reihe von Artikeln, die sich mit den für Wissensmanagement-Prozesse notwendigen Tools auseinandersetzen. Er illustriert zunächst an einem Beispiel aus der Antike die unternehmerische Sorgfaltspflicht gegenüber dem eigenen Informationsbestand, geht dann ausführlich auf das wesentliche Problem ein, das sich bei einer volldigitalisierten Inhaltsverwaltung stellt, erläutert die eigentliche Funktion eines aktiv betriebenen Content Management in Abgrenzung zu blosser Software-Fixierung und beschreibt abschließend die wesentlichen Anforderungen an ein Content Management System (CMS). Zur Einführung in die Thematik wird die Vorab-Lektüre des Artikels von Bernhard v. Guretzky auf dieser Seite, `Wissensmanagement und Content Management` empfohlen. Ein Beispiel praktischer Anwendung findet sich im Artikel `Content Management bei E-Plus`.

Content Management in der Antike

Als Ptolemäus I. - einer der fähigsten Generale Alexanders des Großen, dem bei der Aufteilung des Alexanderreichs unter den Diadochen ägypten zugesprochen wurde - die berühmte Bibliothek von Alexandria gründen liess, schwebte ihm ein Ort vor, an dem alles Wissen dieser Welt versammelt sein sollte. Der Auftrag an den Initiator und ersten Bibliothekar, Demetrios von Phaleron (350-280 v. u. Z.) lautete, alle Bücher dieser Welt zu beschaffen. Demetrios und seine Nachfolger machten sich an die Arbeit, wobei sie die Mittel dem Zweck unterordneten - sie ließen Such-Agenten im ganzen Mittelmeerraum nach Büchern suchen; Schiffe, die dank Alexandrias Bedeutung als Handelszentrum in großer Zahl im Hafen von Alexandria einliefen und manchmal Schriftrollen von wissenschaftlichem Wert an Bord hatten, wurden gezwungen, diese den Kopisten der Bibliothek zum Abschreiben zur Verfügung zu stellen, woraufhin sie dann diese Abschriften wieder in Empfang nehmen durften. Die Originale verblieben in der Bibliothek. Vermutlich war die so entstandene Sammlung im Museion von Alexandria mit ihren 400 000 bis 700 000 Buchrollen das grösste `Informationszentrum` jener Zeit. Der Clou dieses antiken Wissenspools aber bestand darin, dass die Rollen nicht nur - wie in anderen Bibliotheken auch - inventarisiert wurden, sondern dass die Bibliothekare ihre Schätze systematisch ordneten, d. h. eine antike Buchverzeichnung schufen. Schon unter Demetrios, dem ersten Leiter der Bibliothek, entstanden Methoden der Textkritik, die für die gesamte antike Philologie maßgeblich werden sollten. Kallimachos von Kyrene, einer der grössten hellenistischen Dichter und Grammatiker, entwickelte dann auf geschätzten 120 Buchrollen sogenannte Pinakes, annotierte Bestandsverzeichnisse mit all jenen Angaben, die wir heute als Metainformationen von Dokumenten zu bezeichnen pflegen: Autor samt Bibliographie, Entstehungszeitraum, genauer Zeilenumfang und die einleitenden Sätze des jeweiligen Werkes. Auch die Rollen, die das eigentliche Werk enthielten, wurden mit einem Etikettierungssystem versehen, das es ermöglichte, sie zu identifizieren und bezüglich Inhalt zu klassifizieren, ohne sie dazu auch nur aus den Regalen ziehen zu müssen. Man erkennt hier den wohl ersten Versuch in der Geschichte der Zivilisation, das Wissen der Welt nicht nur zu sammeln, sondern auch zu systematisieren - mit dem Ziel seiner sofortigen Verfügbarkeit.

Es sollte sich schon bald herausstellen, dass sich derart sorgfältig betriebenes Content Management - um den Schlüsselbegriff dieses Artikels hier gleichsam durch die Hintertür einzuführen - bezahlt macht. Als Caesar sich nach seiner Landung in ägypten in den Geschwisterzwist zwischen Kleopatra und ihrem Bruder Ptolemäus XIII. hineinziehen ließ und plötzlich unversehens im Hafen von Alexandria um sein Leben kämpfen mußte, ließ er die Flotte des Ptolemäus anzünden, wobei auch eine Außenstelle der Bibliothek mit ca. 40.000 Schriftrollen den Flammen zum Opfer fiel - eine Katastrophe, die schon damals kaum in Gold aufzuwiegen gewesen wäre. Die oben dargestellten Strukturierungsmaßnahmen der verlorengegangenen Medien und ihrer Inhalte gab den Bibliothekaren und wissenschaftlichen Mitarbeitern jedoch eine wesentliche Information in die Hand - sie wußten genau, was verloren war, d. h. wonach sie zur Wiederbeschaffung suchen mußten, und diese Informationen - sowie eine zugegebenermaßen durchaus rigide Wiederbeschaffungspolitik - versetzte sie in die Lage, den Bestand der wertvollsten der verlorengegangenen Dokumente nach nur rund 30 Jahren wiederaufzufüllen.

Man sollte sich nicht einbilden, die oben beschriebenen Methoden der Dokumentenstrukturierung und -klassifizierung seien heute, im Zeitalter der digitalen Medien und Medienspeicherung eine Selbstverständlichkeit. Nicht nur der wirksamen Begegnung von Datenverlust - auch der Auswertung von vorhandenem Datenmaterial stehen im Gegenteil gravierende Schwierigkeiten im Wege. Tatsächlich haben die 90´er Jahre des 20. Jahrhunderts alle Aussichten, als das undokumentierteste Jahrzehnt in die Geschichte der Inhaltsaufbereitung einzugehen. Den in diesem Zeitraum rapide wachsenden Möglichkeiten der Speicherung digitaler Medienobjekte stehen mangelhafte Strukturierungsmöglichkeiten der eigentlichen Inhalte dieser Objekte gegenüber, was ihrer Wiederauffindbarkeit - von Wiederverwerwendbarkeit gar nicht zu reden - äußerst störend im Wege steht. Auf Server- und PC-Festplatten größerer Unternehmen befindet sich Datenmaterial von unvorstellbaren Ausmassen - unstrukturiert und für die Weiterverwertung deshalb verloren. Schätzungen gehen davon aus, dass 90% aller Unternehmensdokumente Inhalte in unstrukturierter Form enthalten, dabei verbraucht eine moderne Volkswirtschaft ungefähr ein Viertel ihrer Ressourcen für Informations- i. e. Inhaltsgenerierung und -verwaltung.

(vgl. Rothfuss/Ried, 2001, S. 16)

Laut Untersuchung eines führenden Marktforschungsunternehmens sollen die Verluste, die Unternehmen und Dienstleistern durch schlecht aufbereitete Informationsquellen und deren mangelhafte Pflege bis zum Jahr 2003 entstehen werden, rund 31, 5 Mrd.$ betragen.

(vgl. Onlinemarketer Digest, Content Management, Teil 1, Einführung - Virtueller Aufbruch)

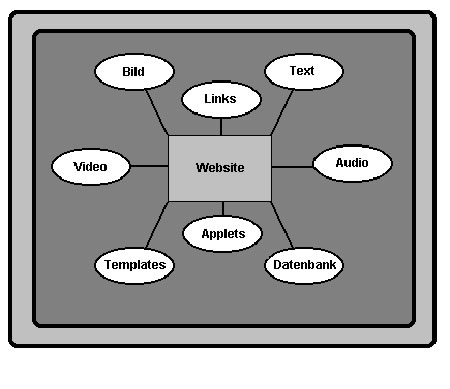

Zusätzliche Brisanz erhält diese Problematik dadurch, dass in Folge des rasanten Anstiegs der Geschwindigkeit der Datenübertragung im World-Wide-Web – Stichwort Flatrate - ein entsprechender, an den heute üblichen Standards orientierter Webauftritt mit einer adäquaten Bereitstellung von hochwertigen und tagesaktuellen Informationen nicht nur für Unternehmen der Medienbranche mittlerweile zu einer conditio sine qua non geworden ist. Denn er gehört in zunehmendem Maße zum festen Bestandteil der Wertschöpfungskette eines Unternehmens, wie sich an der Entwicklung elektronischer Bestellvorgänge und Abwicklung von Kundenaufträgen unschwer ablesen lässt. Dazu kommen noch als weitere Beispiele für die gestiegenen Anforderungen das firmeninterne Intranet und das Geschäftspartner und Lieferanten einbeziehende Extranet: auch hier ist der Zweck der übung ein reibungsloser Austausch mehrwertschöpfender Informationen, die eine beständige Pflege und Veredelung der Inhaltsträger, sprich des gespeicherten Datenmaterials verlangen. Genau dies aber ist deshalb so schwierig und anspruchsvoll, weil schon bei einem Webauftritt die unterschiedlichsten Dateiformate zur Ansicht gelangen, die alle einen je eigenen Verarbeitungs- und Aufbereitungsprozess beanspruchen. Die Bandbreite möglicher Dateiformate, deren Darstellung heutzutage bei Webauftritten gefragt sind, lassen sich aus folgendem Schaubild ersehen:

|

entn. aus Frank Balling, Content Management Systeme)

Noch komplexer sieht es bei Intra- und Extranet aus. Hier werden häufig Ziele aktiven Wissensmanagements verfolgt (vgl. auf dieser Seite Bernhard v. Buretzky, Die Bedeutung des Wissensmanagement und seine Implementierung mittels Intranet und Unternehmensportalen), was ebenfalls reibungslosen Datenaustausch voraussetzt und damit weitere Formate ins Spiel bringt, wie z. B. CAD-/CAE-/CAM-Formate aus der Produktentwicklung. Die Frage, die sich bis hierhin stellt, lautet also: wie schafft man es, benötigte Informationen überhaupt aufzufinden, wie trennt man veraltetes von aktuellem, wie verwaltet und katalogisiert man völlig unterschiedliche Dateiformate, macht sie zugänglich und stellt sie auf einer möglichst einheitlichen Benutzeroberfläche dar? Um das zu beantworten, ist es hilfreich, sich die gestellte Problematik einmal etwas genauer anzusehen.

Struktur und Gestalt

Es gibt eine ganze Reihe von Anforderungen an ein CMS, auf die wir auch noch eingehen werden, doch ein Problem ist zentral und letztendlich der Anstoß zu und Grundlage der Entwicklung von Content Management Systemen: die Trennung von Struktur, Gestalt und Inhalt eines Dokumentes. Ohne diese Trennung ist die gesamte Konzeption von Content Management hinfällig, alle oben formulierten Fragen hängen allein von ihr ab, dazu noch etliche weitere, als deren wichtigste hier noch die Weiterverarbeitung durch unterschiedliche Applikationen genannt sei. Die eigentliche Bewandtnis dieser Trennung ist nicht so ganz einfach zu verstehen und soll deshalb hier genauer erläutert werden, als dies in Beiträgen zum Thema üblicherweise geschieht.

Als Dokumente werden in diesem Artikel alle Dateien bezeichnet, die sich mit üblichen Anwendungen öffnen lassen. So ist z. B eine PDF-Datei ein Dokument, weil es sich mit Adobe Acrobat öffnen lässt. Natürlich - das sollte man nicht übersehen - kann ein Dokument aus einer ganzen Gruppe unterschiedlicher Dateierweiterungen bestehen.

Das Publizieren eines Dokumentes bedeutet nichts anderes, als seinen Inhalt und seine Gestalt zur Darstellung auf welchem Medium auch immer (Papier, CD-Rom, Internet) zu bringen und dazu werden beim Publizieren verschiedene Textverarbeitungs-/Satzprogramme verwendet, die ein anspruchsvolles und professionelles Ergebnis versprechen, und denen trotzdem eine möglichst weitgehende Automatisierung innewohnt, z. B. MS Word, Adobe Pagemaker bis hin zu Framemaker+SGML oder Macromedia Director. Dabei hat man stets das Problem Mengensatz versus Akzidenzsatz, also hohen Mengensatz gegen hochwertiges Layout mit allen subtilen Feinheiten der Platzierung, Balance, Variation etc. In der Praxis aber wird der Buchsatz heute schon immer öfter in MS Word erstellt, womit man vielleicht ein zu 80 % befriedigendes Ergebnis erhält, der Rest wird im Akzidenzsatz, z. B. mit QuarkXpress, auf 95 % getrimmt, die letzten 5 % wären dann so aufwändig, dass sie wirtschaftlich nicht zu rechtfertigen sind. Das Ergebnis ist ein Dokument, deren Inhalt und Gestalt bis tief ins binäre Dateiformat hinein miteinander verzahnt sind und genau diese Vermischung ist für die Suche nach Informationen, im World-Wide-Web oder im Intranet, und einen Haufen weiterer Dinge (s. o.) äußerst nachteilig. Warum ist das so? Was steckt hinter der bei Content Management Systemen ständig beschworenen Trennung von Inhalt, Struktur und Gestalt?

Inhalt und Gestalt, die beiden wesentlichen Aspekte einer jeden Publikation auf welchem Medium auch immer, sind strukturell grundverschieden, sie verhalten sich wie Gegenspieler. Die Struktur von Inhalten besteht in ihrem logischen Verhältnis zueinander, also der Gliederung in Absätze, Textparagraphen, Unterkapitel und Kapitel, sie ist mithin hierarchisch geordnet. Da das eigentlich Wesentliche des Inhalts in seiner Bedeutung, seiner Aussage besteht, orientiert sich dessen Autor bei Erstellung dieser hierarchischen Struktur an eben diesen Punkten. Die Gliederung, mithin Struktur eines Textes steht also, das bleibt festzuhalten, mit seiner inhaltlichen Aussage in einem Zusammenhang.

Gestalt dagegen beschreibt die visuelle Anordnung gleichartiger Objekte, z. B. Text und Graphik. D. h., eine Gestaltsbeschreibung analysiert eine Seitenfolge, indem sie alle zweidimensionalen Inhaltsbestandteile in genau zu beschreibenden Positionierungen wie relative gegenseitige Lage, Drehung zur Waagerechten, die x-Koordinate einer Spalte bei mehrspaltigem Text usw. angibt. All dies dient der optischen Darstellung, die mit der inhaltlichen Aussage keineswegs in direktem Zusammenhang steht. Die graphische Gestaltung eines Printmediums wie Max ist unendlich viel aufwendiger als die einer Fachpublikation wie z. B. der Politischen Vierteljahreshefte , über einen inhaltlichen Vergleich beider Publikationen schweige ich mich lieber aus. Das alles klingt banal, ist es aber nicht. Denn ein Publishing-Tool ist bei der Behandlung dieser beiden wesentlichen Aspekte, Struktur und Gestalt, für die programmgesteuerte Automatisierung zuständig und die Frage ist, welcher der beiden Aspekte darunter mehr leidet. Zur Beantwortung suche man sich ein beliebiges, von einem anderen Autor verfasstes Dokument aus dem Firmenintranet und versuche, über die Strukturierung Informationen über den Inhalt zu gewinnen. Man wird die gewählte hierachische Anordnung, die doch strikt unter dem Primat der inhaltlichen Aussage stand, nur nachvollziehen können, wenn man den Inhalt liest. Was das bei durchaus üblichen 500.000 auf Festplatten der Abteilungsserver gespeicherten Dokumenten bedeutet, muß ich nicht weiter ausführen. über das Layout dagegen erhalte ich über die Formatvorlagen bei MS Word oder Cascading Style Sheets (CSS) bei HTML-Dateien weit umfassendere Angaben als über den Inhalt. Weiter unten jedoch werden wir sehen, dass sie den Inhalt auch nicht ganz ausschließen.

Natürlich gibt es seit geraumer Zeit Strukturierungssprachen wie TeX oder SGML, die für die Weiterverarbeitung von Texten die benötigte Strukturierung zu liefern in der Lage sind. Sie eignen sich dafür um so schlechter, die Variabilität eines gehobenen Layouts zu beschreiben. Man kann mit ihnen schlecht verwandte oder gar strukturell nicht mehr zu unterscheidende Inhalte räumlich aufteilen und verschiedenartig gestalten, beispielsweise einen Produktkatalog mit unterschiedlich großen Abbildungen und Text, der mal 2-, mal 5-spaltig, mal mit und mal ohne Produktabbildung als Aufmacher erscheinen soll. Derlei wird deshalb heute in der Regel als manueller Satz in einem Akzidenzsatzprogramm wie QuarkXpress bearbeitet und landet dann im Internet als PDF-Datei. Für die Nachbearbeitung sind solche Dokumente verloren (s. Rothfuss/Ried, 2001, S. 10/11).

Doch ungeachtet des für die Informationssuche und Weiterverwertung ungünstigen Umstandes, dass sich Aussagen über optische Merkmale eines Dokuments leichter automatisieren lassen als solche über den Inhalt, finden wir bei den gängigen Textverarbeitungswerkzeugen nicht den Ansatz einer Trennung dieser grundverschiedenen Bestandteile eines Dokumente vor. Das ist auch kein Wunder, denn ihre - höchst anspruchsvolle - Aufgabe besteht ja in der Gestaltung von Inhalt , also der Vermischung von etwas Gegensätzlichem. Die Autoren von `Content Management mit XML`, Gunther Rothfuss und Christian Ried, haben an einem einfachen Beispiel erläutert, wie diese Vermischung in der Praxis aussieht (S. 39-49): Sie haben ein kurzes Memo in MS Word 2000 im rtf-Format verfasst, jeder kann das kleines Experiment für sich wiederholen. Das Memo wurde in HTML gespeichert, die Browserdarstellung sah der Word-Datei täuschend ähnlich. Anschließend öffneten sie das HTML-Dokument wieder ohne Probleme mit Word, so als sei es ein Dokument einer beliebigen Anwendung und liesse sich mit beliebigen Anwendungen weiterverarbeiten, was innerhalb von MS Office ja auch stimmt. Nun untersuchten sie den Quellcode, der sogar XML-Tags enthielt, unter der Fragestellung, ob die geforderte Trennung von Inhalt und Layout hier gegeben sei und stellten fest, dass es sich offenbar um eine Word-spezifische Weitergabe von Befehlen für MS Office handelte, die zwar eine Browserdarstellung ermöglichten, aber keine für eine nachfolgende Inhaltsextraktion notwendige Trennung von Darstellungs- und inhaltsbezogenen Befehlen, mithin ist die Weiterverarbeitung mit Office-fremden Applikationen nicht möglich. Anschließend verfassten sie das gleiche Memo in HTML. Im Header tauchte ein Style Sheet auf, dass den HTML-Code zusätzlich formatierte. Auch hier war also eine Trennung von inhaltlichem und formatierendem Charakter eines Tags nur bedingt möglich, wie es überhaupt bei der Formatierung nicht ganz leicht ist, zu entscheiden, was hier eigentlich für die Struktur, und was für die Gestalt zuständig ist: ein Dokument-Header enthält einerseits die Überschrift (=Inhalt), andererseits sagt er dem Browser, die Überschrift in einer bestimmten Schrift und Größe darzustellen und gibt Farben in Hexadezimalwerten an (=Gestalt). HTML ist ganz einfach eine festverdrahtete SGML-DTD (=Document Type Definition) mit fest definierten Auszeichnungstags. Das Problem ist also: wollte man ein HTML-Dokument nachträglich so strukturieren, dass Inhalt und Layout wirklich getrennt würden, müßte man alle formatierenden und gestaltenden Tags entfernen. Dabei nähme man, wie wir am Beispiel Dokument-Header gesehen haben, inhaltliche Angaben mit heraus, deshalb sind HTML-Dokumente nicht wirklich strukturierbar.

Diesem Umstand haben wir es u. a. zu verdanken, dass wir im Internet auf absehbare Zeit nur mittels Volltextsuche arbeiten können. Man gebe einmal in Altavista oder Google das Suchwort `Content Management` ein - eine unsinnig hohe Informationsflut ohne jede inhaltliche Gewichtung ist das Ergebnis, denn das Ranking, das diese Suchmaschinen anbieten, basiert auf der Anzahl der Suchwörter in den gespeicherten Dokumenten, was über die inhaltliche Qualität wenig bis gar nichts sagt. Zur Illustration: Wenn ich im Rahmen meines Studiums eine Hausarbeit über die Entstehung der Jurisprudenz in Bologna schreibe, wird der korrigierende Professor kaum die Häufigkeit der Worte `Jurisprudenz` und `Bologna` im Text als Bewertungskriterium heranziehen. Als Alternative kommen nur Kataloge à la Yahoo in Betracht, deren Inhalte tatsächlich von menschlichen Rezensenten durchgesehen worden sind, und die somit wenig Chance haben, wirklich aktuell zu bleiben.

XML als Problemlösung

Der Praxistest von Rothfuss und Ried enthält noch einen 3. Teil, den ich dem Leser bis jetzt vorenthalten habe. Sie schrieben das Memo in XML, in Tags ohne jede Gestaltungsinformation, aber mit Angaben zu Datum, Autor, Empfänger, Thema und Text. Sie schufen damit Strukturangaben, die sowohl den Inhalt, als auch die dazugehörigen Metainformationen wie Autor, Datum und Titel umfassten, wer sich an die Einleitung erinnert, also genau die Informationen, die die Alexandriner Bibliothekare auf ihren Pintakes festhielten. Anschließend probierten sie für die Browserdarstellung sowohl CSS (=HTML-Formatierung) als auch XSL (XML-Formatierung). Das CSS verschwieg die Metainformationen, das XSL-Stylesheet stellte sie im Browser dar. Wesentlich für unser Problem ist, dass das XSL-Stylesheet unabhängig von den text- und metainformationsbezogenen, strukturierenden Tags ist, XML mit XSL-Formatierung also endlich Inhalt, Struktur, Gestaltung und Formatierung von einander ablöst und einzeln manipulierbar macht. Auch Automatisierbarkeit ist durch die Klarheit und Standardisierung von XML weitgehend gegeben, zudem lassen sich alle Arten von Daten in XML beschreiben, womit wir uns mitten im Aufgabenbereich des Content Management befinden.

Planungsfaktoren im Content Management

Rothfuss und Ried, 2001, S. 52, definieren Content Management als die `systematische und strukturierte Beschaffung, Erzeugung, Aufbereitung, Verwaltung, Präsentation, Verarbeitung, Publikation und Wiederverwendung von Inhalten.` Dies ist ein Vorgang, eine Prozesskette intentionaler, zielgerichteter Handlungen, die prinzipiell - denken Sie an die alexandrinischen Bibliothekare - nichts mit dem Einsatz von Software zu tun hat. Natürlich kommt sie im Zeitalter digitaler Medien - wir schreiben heute eben nicht mehr auf Papyrus - irgendwann ins Spiel, doch geht Content Management der Beschaffung eines Content Management Systems voraus, letzteres ist dann nur noch Mittel zum Zweck. Umgekehrt formuliert: bevor Software angeschafft wird, sollte man ein Lastenheft für sie erstellt haben, dem geht die Definition des Endziels und die Analyse der dazu notwendigen Zwischenschritte voraus. Diese Zwischenschritte stellen je eigene Prozesse mit je eigenen Erfordernissen unter Beteiligung verschiedener Gruppen von Mitarbeitern mit je eigenen Aufgabenbereichen und Verantwortlichkeiten dar. Das vorhandene Datenmaterial muß überschaut, kategorisiert und den je eigenen Prozessschritten mit ihren Publishingzielen zugeordnet werden. Dabei müssen so schwierige Fragen entschieden werden, wie: welche Daten verfügen über welchen Lebenszyklus und gehören in eine zu erstellenden Content Base , müssen also nachträglich strukturiert werden (bereits strukturierte Daten werden Sie, s. oben, eher selten vorfinden).

Wie überwache ich die Arbeitsschritte im Sinne einer effektiven Qualitätskontrolle in inhaltlicher, koordinatorischer und betriebswirtschaftlicher Sicht?

Teilen Sie die Gruppen sinnvoll auf, z. B. in Content Worker (Autoren, Redakteure und Layouter) und Supervisor (Qualitätskontrolle), Programmierer (Script-, Applikations-/Schnittstellen- und Systemprogrammierer) und Administratoren mit leitender Funktion für die Aufgabenverteilung und Qualitätssicherung/Controlling. Das ist eine grobe Einteilung (Content Work, Programmierung, Administration), in der Praxis wird, ganz vom vorhandenen Stock an Mitarbeitern abhängig, eine umfangreichen Delegation von Aufgabenbereichen, Kompetenzüberlassung, Wechsel von Verantwortungsbereichen stattzufinden haben. Wer sich hier bereits mit aktivem Knowledge Management befasst hat, ist wesentlich im Vorteil.

Auf diese Weise wird eine treffsichere, den individuell verschiedenartigen Anforderungen angepasste Auswahl eines Tools ermöglicht, die einen Return on Investment (ROI) nicht nur verspricht, sondern auch hält.

Anforderungen an ein CMS

Im Grunde ist es ein unsinniges Unterfangen, in einem allgemein beschreibenden Artikel einen Anforderungskatalog für ein CMS aufstellen zu wollen.

Vielmehr divergieren Problemstellungen und Zielsetzungen, die in einem solchen Katalog zum Ausdruck gebracht werden, beträchtlich, so dass er letztendlich mehr schadet als nützt, weil er etwas vorspiegelt, das in der Realität nicht vorkommt: Allgemeingültigkeit.

Andernfalls könnte man sich das oben beschriebene Content Management auch sparen. (Von Knowledge Management ganz zu schweigen - wenn alle die gleichen Problemstellungen hätten, hätte auch alle die gleichen Mitarbeiter. Klonen gäbe es dann schon längst).

Daher sei an dieser Stelle auf die Seite www.contentmanager.de/itguide/ verwiesen, die nicht nur die größte Marktübersicht an Systemen bietet - sondern auch einen Comparator zum Systemvergleich, bei dem sich der Anforderungskatalog individuell verschieden formulieren lässt.

Dessenungeachtet lassen sich gemeinsame Merkmale der größten Anbieter in diesem Markt selbstverständlich feststellen, das Content Management muss klären, was man davon braucht, und was nicht.

Wesentlich ist die Content Base . Sie enthält alle zur Aufbewahrung und (getrennten) Weiterverarbeitung bestimmten Daten eines Unternehmens, auf die dazu notwendige Trennung von Struktur, Gestalt und Inhalt wurde oben ausführlich eingegangen. Das ermöglicht idealerweise, dass Daten nicht als in sich geschlossene Dateien gespeichert, sondern ihre Einzelkomponenten nur referentiell zueinander, aber je einzeln zugänglich verwaltet werden. Bei einer Word-Datei, die eine Graphik enthält, ist das noch simpel, es kann aber sehr schnell höchst komplex werden (HTML-Datei mit eingebundenen 3D-Objekten).

Der Nutzer teilt diesem Datenspeicher mit, dass er einen bestimmten Inhalt zu lesen oder zu bearbeiten wünscht und bekommt sie im Rahmen von Zugriffsregelungen zur Verfügung gestellt. Dabei bietet die Benutzeroberfläche des CMS üblicherweise die einzige Zugriffsmöglichkeit, wer über viel komplexes Datenmaterial verfügt, benötigt ein Application Programming Interface (API), eine Programmierschnittstelle für die Bearbeitung mit externen Applikationen. Sie werden auch häufig zur Befüllung der Content Base durch relationale oder objektorientierte Datenbank-Management-Systeme verwendet. Prinzipiell können die Daten aber in einem Dateiverzeichnis oder DBMS vorgehalten werden, nicht ungeschickt ist auch eine Mischung aus beidem, also Speicherung komplexer Dokumente im Dateisystem, strukturelle Informationen in der Datenbank, von dort werden sie von verschiedenen Scripts gelesen und in beliebiger Auswahl, das ist das eigentlich Wichtige, zur Verfügung gestellt.

Dabei ist die Zugangskontrolle (z. B. LDAP) von entscheidender Bedeutung. Schon die Suchmaschine für Anfragen muß wissen, wer wonach fragen darf, darüber hinaus muß verhindert werden, dass zwei Mitarbeiter unabhängig voneinander auf das gleiche Dokument zugreifen können. Dies lässt sich durch Check in/Check out-Funktionen erreichen. Darüberhinaus empfiehlt sich die Einrichtung von Benutzergruppen/-rollen/profilen durch die Zuweisung der jeweiligen Aufgaben von z. B. Redakteuren, Layoutern etc. Bei hoher Mitarbeiterzahl erfolgt das durch Einteilung in Gruppen.

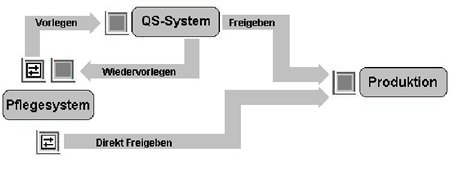

Zur Abbildung des Workflow - Inhalte werden erstellt, freigegeben, publiziert, Webseiten werden konzipiert, gestaltet, mit den Inhalten zusammengeführt, ganz zu schweigen vom Beispiel Produktentwicklung, all das in einem vielstufigen Prozess mit unterschiedlichen Stufen der Freigabe, Beteiligung verschiedener Gruppen (s. oben) - ist weiterhin eine Protokollfunktion vonnöten, die auf die Zugangskontrolle aufbaut und Datum, Uhrzeit, Dauer etc. in eine Protokolldatei schreibt.

Zusätzlich ermöglicht sie einen Rollback, über den man unerwünschte änderungen rückgängig machen, kurz, den gesamten Entstehungsprozess eines Dokumentes zurückverfolgen kann.

Die Steuerung des Workflow gehört zu den anspruchsvollsten Aufgaben eines CMS. Alle einbezogenen Objekte befinden sich in unterschiedlichen Zuständen. Die Weiterverarbeitung eines einzelnen von ihnen stößt u. U. Veränderungen bei anderen an, daher richtet sich eine erfolgreiche Implementierung an der Maßgabe, wie Zustandsänderungen und Auswirkungen auf andere Objekte vom System definiert werden, wie deren Strukturbeschreibungen (Metainformationen) gespeichert werden, u. v. a., wie eng der Workflow mit Gruppenprofilen und Benutzerrechten verwoben ist.(vgl.Rothfuss/Ried 2001, S. 84)

Diese Graphik veranschaulicht den Prozess. (entn. aus Frank Balling, Content Management Systeme )

|

Die Anfragefunktion muß nicht nur beispielsweise alle Dokumente auffinden, die den geplanten Fertigstellungstermin überschritten haben, sondern sich auch in komplex strukturierten, d. h. hierachisch gegliederten Dokumenten (s. oben Struktur und Gestalt) zurechtfinden, beispielsweise in den Unterkapiteln oder Fuß-/Endnoten eines technischen Handbuchs. Dafür empfiehlt sich als Anfragesprache XML-QL (=XML-Query Language).

Die Versionierungsfunktion eines CMS ermöglicht die parallele Verwaltung von Dokumenten, deren Veröffentlichung in unterschiedlichen Versionen vorgesehen ist - ein Text als Abstract, Kurzfassung, `Vollversion`, oder unterschiedliche Endabnehmer - Geschäftskunden, Unternehmenspartner etc. erhalten je eigene Versionen. Damit in Zusammenhang steht auch die Mehrsprachfähigkeit , die gleiche Inhalte in mehr als einer Sprache verwaltet, woraus sich bis in die Dokumentenstruktur einschneidende änderungen ergeben können.

Die Aggregatsfunktion nimmt z. B. die Pflege von Hyperlinks auf sich und ist für die Verwaltung zusammenhängender Dokumente verantwortlich. Da dies im wesentlichen über Struktur-Informationen geschieht (s. oben), ist dies wieder einmal ein klassischer Aufgabenbereich für XML und seine Linking-Mechanismen.

Für weitergehende Lektüre empfehle ich das Kapitel 4, Funktionen von Content Management, bei Rothfuss/Ried, 2001, S. 51-87, als Fallbeispiel ist auf dieser Seite Content Management bei E-Plus von Oliver Christ und Volker Bach beschrieben worden. Hier erhält man viel des gerade Beschriebenen an einem konkreten Beispiel erläutert.

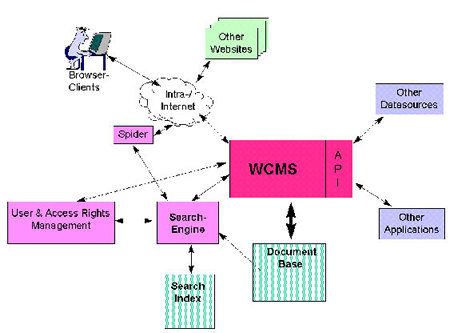

Folgende Graphik bietet einen guten überblick: (entn. aus www.netcologne.de/~nc-starkedr/wcm.htm )

|

Fazit

Zielgerichtetes Content Management ist ein Mittel, mehrwertbehafteten Inhalt zu strukturieren und zu verwalten. Schon das Beispiel der Bibliothek von Alexandria zeigt, dass dies von lebensnotwendiger Bedeutung sein kann. Softwaregesteuertes Content Management setzt eine intensive Planung unter Einbeziehung aller Parameter voraus, ohne die eine vernünftige Tool-Auswahl in einem Markt, der von kostenlosen Open-Source- bis hin zu High-End-Anwendungen, die 6-stellige Summen verschlingen können, alles anbietet. Anforderungskataloge sind hier nur zu einem groben Überblick geeignet.

Literatur / Links

Gunther Rothfuss und Christian Ried, Content Management mit XML, Berlin, Heidelberg 2001.

Heino Büchner, Oliver Zschau, Dennis Traub, Rik Zahradka, Web Content Management. Websites professionell betreiben. Bonn 2001.

Charles F. Goldfarb, Paul Prescod, XML Handbuch, München 1999.

Henning Behme, Mehr Inhalt, in: iX 10 (2001), S. 54-57.

Oliver Zschau, Form und Inhalt unterscheiden, in: Computerwoche extra 7, (9/2001), S. 8-9.

Gerhard Versteegen, Durchleuchtet. Die Zukunft von Content Management Systemen unter der Lupe, in: IT Management 9 (2001), S. 66-73.

Bernhard v. Guretzky, Wissensmanagement und Content Managent

Gernot Starke, Web Content Management.

Holger Nohr (HG), Content Management, in: Arbeitspapiere Wissensmanagement (Hachhochschule Stuttgart) 11/2000.

Whitepaper Gauss-Interprise, Anforderungen an Content Management Systeme beim Aufbau intelligenter Enterprise Portale

www.contentmanager.de/itguide/ (mit Marktübersicht und Comparator).

Kommentare

Das Kommentarsystem ist zurzeit deaktiviert.

Schlagworte

Dieser Beitrag ist den folgenden Schlagworten zugeordnet